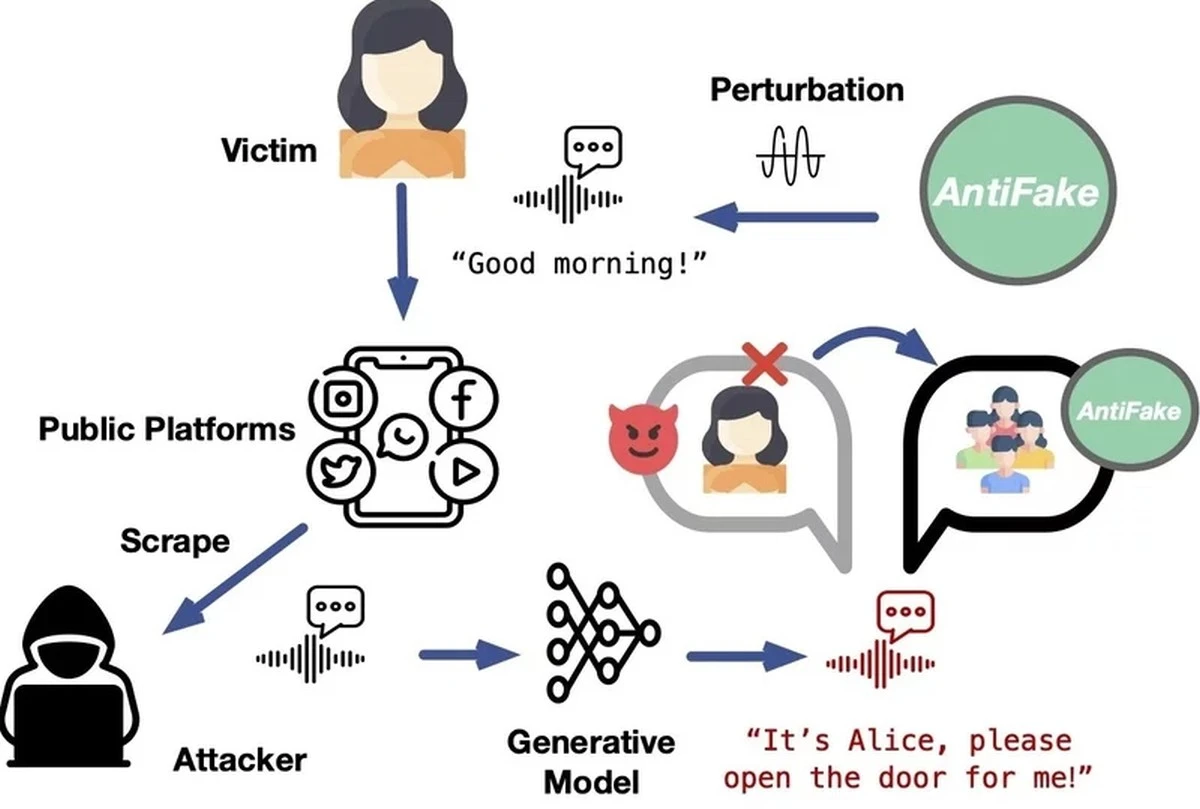

Sztuczna inteligencja ma wiele użytecznych zastosowań. Niemniej, przynajmniej pod niektórymi względami jest źródłem zagrożenia. Z jej użyciem można tworzyć na przykład przekonujące materiały typu deepfake. Do odtworzenia w takich materiałach głosu wybranej osoby wystarczy nawet krótkie nagranie. To powiedziawszy, właśnie powstało narzędzie, które ma sprawiać, by kradzież czyjegoś głosu była niemożliwa – narzędzie o nazwie AntiFake.

Deepfake’i niszczą życia

Tak zwane deepfake’i to wbrew pozorom zagrożenie nie tylko dla znanych aktorów, streamerów czy polityków. Miały już miejsce przypadki, w których cyberprzestępcy fałszowali wypowiedzi przeciętnych obywateli, by wykorzystywać je do wyłudzania pieniędzy od ich bliskich. Ponadto replikowane głosy mogą być wykorzystywane do omijania systemów bezpieczeństwa wykorzystujących rozpoznawanie mowy.

Chociaż już od jakiegoś czasu istnieją rozwiązania, które pozwalają ustalić, czy wybrany materiał to deepfake, AntiFake to podobno jedno z pierwszych narzędzi, który zapobiega tworzeniu deepfake’ów. Jak to narzędzie działa?

AntiFake, czyli sposób na ochronę swojego głosu

W skrócie, AntiFake znacznie utrudnia systemom sztucznej inteligencji odczytywanie kluczowych cech głosu w nagraniach prawdziwych ludzi. Jednocześnie przetworzone przez niego audio dla ludzkiego ucha podobno brzmi zupełnie normalnie.

„Narzędzie wykorzystuje technikę kontradyktoryjnej SI, która pierwotnie była częścią zestawu narzędzi cyberprzestępców. Teraz używamy jej do obrony przed nimi.”, powiedział jeden z twórców narzędzia, Ning Zhang z Uniwersytetu Waszyngtona w St. Louis. „Trochę psujemy nagrany sygnał audio, zniekształcając go i zakłócając na tyle, by nadal brzmiał dobrze dla człowieka, ale zupełnie inaczej dla sztucznej inteligencji.”

Za sprawą narzędzia AntiFake sztuczna inteligencja nie jest w stanie dobrze odtworzyć głosu człowieka. Gdy spróbuje stworzyć deepfake’a, jej nagranie będzie brzmieć zupełnie inaczej niż oryginalny głos mówiącego. Przeprowadzone dotychczas testy wykazały, że AntiFake wykazuje się skutecznością w ponad 95% przypadków.

Oczywiście, aby AntiFake spełniał swoją rolę, musiałby on stać się natywnym elementem aplikacji i innych rozwiązań umożliwiających rejestrowanie głosu, a w zasadzie także i jego emitowanie. Na razie nie wiadomo, na ile jego implementacja w taki sposób byłaby możliwa. Należy też zadać pytanie, czy można by wytrenować model sztucznej inteligencji, który byłby w stanie obejść przeszkody stawiane przez narzędzie AntiFake.

Źródło: Uniwersytet Waszyngtona w St. Louis, fot. tyt. Canva