Google wprowadzi funkcję multisearch

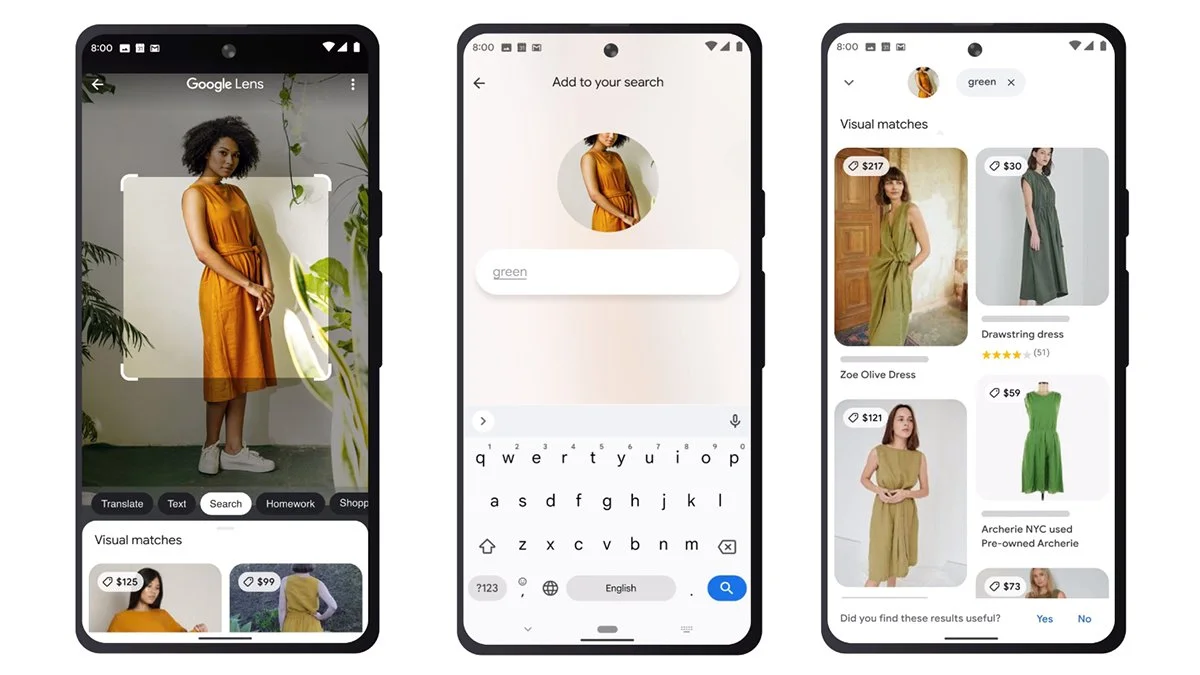

Jak będzie ona działać? W celu rozpoczęcia „zabawy” należy udać się do aplikacji Google (zarówno na Androidzie, jak i iOS) i kliknąć ikonę Obiektywu dostępną na pasku wyszukiwania. Wtedy też wystarczy wybrać dowolny obraz z galerii lub zrobić zdjęcie. Jeśli to zrobimy i przesuniemy palcem w górę, to naszym oczom ukaże się nowa ikona plusa – to właśnie ona pozwoli na dodanie tekstu, który będzie brany pod uwagę przy przeczesywaniu sieci przez algorytm.

Google opisuje nowość w następujący sposób:

W Google zawsze wymyślamy nowe sposoby, aby pomóc Ci znaleźć informacje, których szukasz – niezależnie od tego, jak trudno jest wyrazić to, czego potrzebujesz. Dlatego właśnie dziś wprowadzamy zupełnie nowy sposób wyszukiwania: jednoczesne korzystanie z tekstu i obrazów. Dzięki multisearch w Obiektywie możesz wyjść poza pole wyszukiwania i zadawać pytania dotyczące tego, co widzisz. Aby zacząć, wystarczy otworzyć aplikację Google w systemie Android lub iOS, stuknąć ikonę aparatu z obiektywem i przeszukać jeden ze swoich zrzutów ekranu lub zrobić zdjęcie otaczającego Cię świata, np. stylowego wzoru tapety w lokalnej kawiarni. Następnie przesuń palcem w górę i stuknij przycisk „+ Dodaj do wyszukiwania”, aby dodać tekst.

Gigant z Moutain View podaje przykład próby znalezienia sukienki, która nam się podoba, lecz posiadamy zdjęcie w niekoniecznie preferowanym przez nas kolorze. Wtedy wystarczy dodać np. „zielony” do tekstowych atrybutów, a wyświetlone zostaną wyłącznie zielone sukienki. Mowa tu więc o możliwości zawężania wyników według koloru, marki czy atrybutów wizualnych. Brzmi naprawdę przydatnie!

Samo wprowadzenie funkcjonalności jest możliwe dzięki „najnowszym osiągnięciom w dziedzinie sztucznej inteligencji”, a konkretnie usprawnionemu modelowi AI o nazwie Multitask Unified Model (MUM) – potrafi on przyswajać informacje w różnych formatach. Dostęp do nowości w wersji beta mają jednak na razie mieszkańcy Stanów Zjednoczonych.

Google uspokaja jednak, że za kilka miesięcy pojawi się ona u wszystkich konsumentów. Czekamy!

Źródło i foto: Google