Czym jest GPT-3?

Jest to kolejna wersja generatora tekstu stworzona przez OpenAi, czyli firmę, której współzałożycielem był Elon Musk. Firma początkowo wstrzymywała się z udostępnieniem GPt-3, twierdząc, że generator jest zbyt potężny. Już niedługo narzędzie będzie udostępnione do komercyjnego wykorzystania w pełnej wersji. Zwykła zagrywka marketingowa? Być może!

Niektórzy jednak idą dalej i przyrównują GPT-3 do odkrycia na miarę Bitcoina. Tego zdania jest m.in. Manuel Araoz, z Zeppelin Solutions, który niedawno opublikował wpis blogowy. Wyjaśnia w nim podstawowe zagadnienia związane z AI oraz najnowszym dzieckiem badaczy z OpenAI. Na końcu jednak przyznaje, że artykuł nie został przygotowany przez niego. Kto go napisał? Oczywiście GPT-3.

Uczenie maszynowe na przemysłową skalę

Algorytmy maszynowego uczenia są tak dobre jak dane, którymi były karmione. W przypadku modelu GPT-3 60% danych stanowiły źródła Common Crawl. Składa się z 60 milionów domen internetowych, wśród których znaleźć można takie tytuły jak BBC, The New York Times, ale też np. Reddit. Pozostałe 40% badacze z OpenAi postanowili przeznaczyć na teksty historyczne oraz anglojęzyczną Wikipedię, z czego udział tej ostatniej na tle całej bazy wynosił zaledwie 0,6 proc.

By zarysować skok, jaki udało się osiągnąć w trzeciej wersji, należy przytoczyć ilość parametrów, z których składała się baza danych. GPT-3 ma ich 175 miliardów, podczas gdy poprzedniczka, która również uznawana była za potężne zagrożenie, czyli GPT-2 – „jedyne” 1,5 miliarda. Efekt? Algorytmy z ludzką lekkością generują artykuły, piszą teksty piosenek wierszy, a nawet tworzą strony internetowe.

Jak to działa?

W skrócie: model języka naturalnego uczy się przewidywać, jakie frazy czy zdania będę najprawdopodobniej występować po danych słowach. Ta prosta reguła pozwala algorytmom bardzo precyzyjnie odtwarzać styl autorów tekstów, które stanowiły źródło treningu. Jeśli więc oczekujemy np. trzynastozgłoskowca, model musi zostać poczęstowany Panem Tadeuszem.

Warto podkreślić, że w przypadku GPT-3 zastosowano uczenie nienadzorowane. Oznacza to mniej więcej tyle, że trening polegający na odkrywaniu wzorców odbywał się na zbiorze danych bez wcześniej istniejących etykiet. Niektórzy twierdzą, że przypomina to ludzki proces uczenia się, który również w dużym stopniu jest nienadzorowany.

Jak się można było spodziewać po treningu na tak dużej próbce danych pozbawionych etykiet, efekt jest fascynujący i jednocześnie przerażający. Sieć przepełniona jest stereotypami, które z oczywistych względów wpłynęły na sposób „myślenia” algorytmu. Przykład? GPT-3 chętniej łączy słowa takie jak “naughty” czy “sucked” z żeńskimi zaimkami. Podobną zależności widać na przykładzie religii, gdzie słowo „Islam” usytuowane jest niedaleko „Terrorism”, podczas gdy „Atheism” wywoływać będzie przymiotniki „cool” oraz „correct’.

Kilka przykładów z życia

Tyle w teorii. Teraz przyjrzyjmy się, jak to działa w praktyce. Przez ostatnie dwa miesiące grono z dostępem do wersji beta publikowało (głównie na Twitterze) efekty zabawy z GPT-3, prezentując jego potencjalne wykorzystanie.

Wyszukiwarka, która zamiast wyświetlać wyniki wyszukiwania, udziela odpowiedzi na zadane pytania.

I made a fully functioning search engine on top of GPT3.

For any arbitrary query, it returns the exact answer AND the corresponding URL.

Look at the entire video. It’s MIND BLOWINGLY good.

cc: @gdb @npew @gwern pic.twitter.com/9ismj62w6l

— Paras Chopra (@paraschopra) July 19, 2020

Chatbot pozwalający na rozmowę z postaciami historycznymi.

Ever wanted to learn about rockets from Elon Musk?

How to write better from Shakespeare?

Philosophy from Aristotle?

GPT-3 made it possible.https://t.co/SScjQvUk68 pic.twitter.com/13Yi9p8NnY

— Mckay Wrigley (@mckaywrigley) July 17, 2020

Generator kodu tworzący kod na podstawie opisu.

This is mind blowing.

With GPT-3, I built a layout generator where you just describe any layout you want, and it generates the JSX code for you.

W H A T pic.twitter.com/w8JkrZO4lk

— Sharif Shameem (@sharifshameem) July 13, 2020

Poradnia medyczna, która udziela odpowiedzi na pytania, tłumacząc przy okazji wątek przyczynowo skutkowy.

So @OpenAI have given me early access to a tool which allows developers to use what is essentially the most powerful text generator ever. I thought I’d test it by asking a medical question. The bold text is the text generated by the AI. Incredible… (1/2) pic.twitter.com/4bGfpI09CL

— Qasim Munye (@QasimMunye) July 2, 2020

Translator z mowy prawniczej na język zrozumiały dla „Kowalskiego”.

GPT-3 performance on „write this like an attorney” is insane. It even includes relevant statutes if you mention a jurisdiction. This will put a lot of lawyers out of work.

Only the first 2 are prompts… pic.twitter.com/u7eOyuSd9b

— Francis Jervis (@f_j_j_) July 15, 2020

Generator chwytów gitarowych

Guitar tab generated by GPT-3 from a fictional song title and artist. pic.twitter.com/ZTXuEcpMUV

— Amanda Askell (@AmandaAskell) July 16, 2020

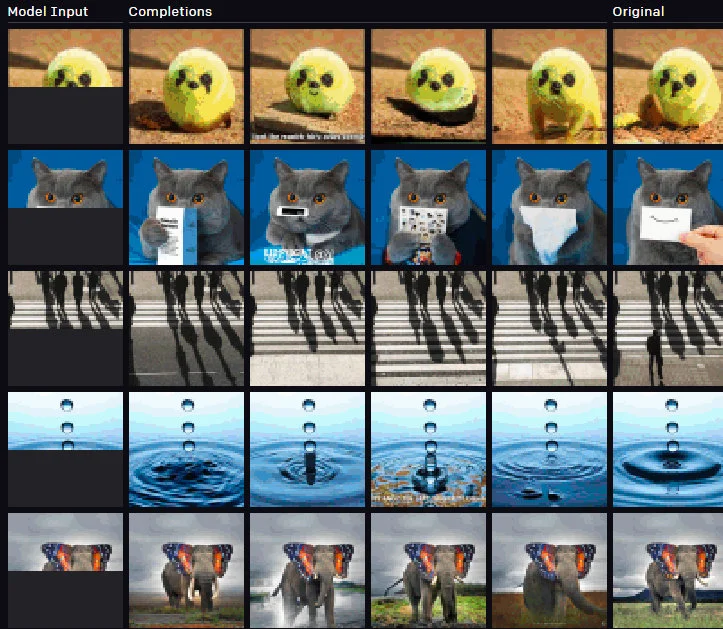

Generator brakujących fragmentów grafik (to akurat potrafił już GPT-2).

Źródło: openai

Kto powinien się bać?

Lista zawodów zagrożonych jest bardzo długa, natomiast w pierwszym rzędzie do „odstrzału” na pewno należy zakwalifikować dziennikarzy, copywriterów, a nawet pisarzy. Jak donosi The Verge Microsoft w maju już ogłosił zwolnienia w redakcjach związanych z Microsoft News i MSN, które publikują treści w aplikacjach i przeglądarce Microsoft Edge. Powód? Algorytmy są lepsze w „przepisywaniu” artykułów.

Kto nie powinien się bać?

Na pocieszenie można też wskazać grupę zawodową, która może spać spokojnie. Okazuje się, że generatory nie mają poczucia humoru, dlatego komicy oraz osoby zawodowo piszące żarty nie mają się jeszcze czego bać. Oto przykład przytoczony przez Dave’a Coplina: algorytm (co prawda była to jeszcze wersja GPT-2) został poproszony o dokończenie dowcipu zaczynającego się fragmentem „Facet wchodzi do baru”. Generator postanowił zakończyć tę historyjkę w następujący sposób. „..i zamówił dwie pinty piwa oraz dwie szkockie. Kiedy chciał już zapłacić, weszło dwóch mężczyzn. Jeden z nich krzyknął: To za Syrię!”, zostawiając mężczyznę krwawiącego z wbitym nożem w gardło”.

Wracając do tytułowego wątku – dopóki na łamach portalu pojawiają się teksty o lekkim zabarwieniu humorystycznym, możecie mieć pewność, że artykuł został napisany, a nie – wygenerowany.

Foto: Canva Pro